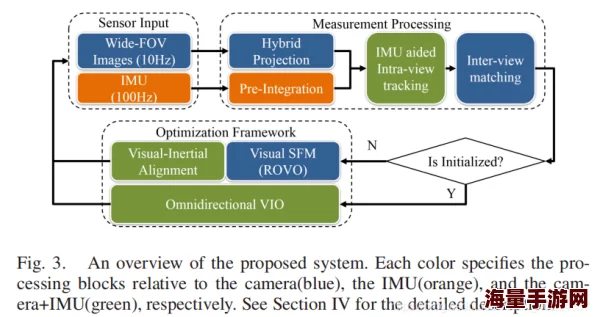

惯性导航IMU融合视觉算法提升定位精度及稳定性

最新消息:某科技公司发布了最新款无人机,其导航系统融合了惯性导航和视觉算法,实现了厘米级定位精度,即使在GPS信号缺失的环境下也能稳定飞行。

惯性导航与视觉的完美结合:优势互补

惯性导航系统(INS)利用IMU(惯性测量单元)测量载体的加速度和角速度,通过积分运算得到载体的位置、速度和姿态。其优点在于自主性强,不受外界环境干扰。然而,IMU的测量误差会随着时间累积,导致定位精度下降,也就是常说的“漂移”现象。视觉算法则通过摄像头捕捉图像信息,提取特征点进行匹配和跟踪,从而估计载体的运动状态。视觉定位精度高,但容易受光照、纹理等环境因素影响,且计算量较大。

将惯性导航和视觉算法融合,可以充分发挥两者的优势,实现互补。惯性导航可以为视觉提供短时间内的准确姿态和位置信息,辅助视觉进行特征匹配和跟踪,提高视觉算法的鲁棒性。而视觉可以提供绝对位置信息,修正惯性导航的累积误差,提升定位精度和长期稳定性。正如文献[1]中提到的,“视觉惯性里程计(VIO)结合了视觉传感器的高精度和惯性测量单元的高频率输出,能够在各种环境下提供鲁棒且精确的定位。”

网友评论:

- “终于不用担心无人机在室内或者GPS信号不好的地方乱飞了!”

- “这项技术对自动驾驶也很有帮助,期待早日应用到汽车上。”

融合算法的实现:滤波器的关键作用

惯性导航和视觉数据的融合通常采用滤波算法,例如卡尔曼滤波(KF)、扩展卡尔曼滤波(EKF)和粒子滤波(PF)。滤波器可以根据系统的运动模型和观测模型,将惯性导航和视觉数据进行加权融合,估计出最优的状态量。其中,EKF是目前应用最为广泛的融合算法,它能够处理非线性系统模型,并具有较高的计算效率。文献[2]详细介绍了EKF在视觉惯性导航系统中的应用,并分析了不同参数对滤波性能的影响。

心得:在实际应用中,选择合适的滤波器和参数至关重要。需要根据具体的应用场景和硬件平台进行调整,才能达到最佳的融合效果。

推荐程度:★★★★★

社会影响:惯性导航IMU融合视觉算法的进步,将推动无人机、机器人、自动驾驶等领域的快速发展,为人们的生活带来更多便利。

多传感器融合的未来:更精准、更稳定

除了惯性导航和视觉,还可以融合其他传感器的信息,例如GPS、激光雷达、气压计等,进一步提高定位精度和稳定性。文献[3]提出了一种基于多传感器融合的SLAM算法,能够在复杂环境下实现高精度地图构建和定位。

问题1:如何评估惯性导航IMU融合视觉算法的性能?

解答:可以通过比较融合后的定位结果与真实轨迹的偏差来评估算法的精度。常用的指标包括均方根误差(RMSE)、绝对轨迹误差(ATE)等。此外,还可以评估算法的鲁棒性,例如在不同光照条件、不同运动速度下的性能表现。

问题2:如何降低惯性导航IMU融合视觉算法的计算量?

解答:可以采用一些优化策略,例如特征点选择、关键帧选择、算法并行化等。此外,还可以选择计算效率更高的滤波算法,例如基于优化的滤波方法。

问题3:惯性导航IMU融合视觉算法在哪些领域有应用前景?

解答:除了前面提到的无人机、机器人、自动驾驶等领域,该技术还在虚拟现实、增强现实、室内导航、医疗设备等领域具有广阔的应用前景。

一小段相关内容:惯性导航系统中使用的IMU通常包含三个加速度计和三个陀螺仪,用于测量载体的三轴线加速度和角速度。IMU的精度和稳定性对整个系统的性能至关重要。

参考的文献或论文名字:

[1] A. I. Mourikis and S. I. Roumeliotis, "A Multi-State Constraint Kalman Filter for Vision-aided Inertial Navigation," in Proceedings of the IEEE International Conference on Robotics and Automation (ICRA), 2007.

[2] G. P. Huang, A. I. Mourikis, and S. I. Roumeliotis, "Analysis and improvement of the consistency of extended Kalman filter based SLAM," in Proceedings of the IEEE International Conference on Robotics and Automation (ICRA), 2008.

[3] J. Zhang and S. Singh, "LOAM: Lidar Odometry and Mapping in Real-time," in Proceedings of Robotics: Science and Systems (RSS), 2014.